DeepSeek是一款最近异常火爆的智能AI助手,性能相当强大,可以帮助我们撰写以及整理文档,提高我们的工作效率,还可以回答我们在生活、学习、工作中遇到的各种问题,帮助我们快速的解决难题。甚至是撰写游戏代码,让我们快速编程。

然而,随着用户数量的激增,DeepSeek的在线服务时常面临访问压力,导致响应延迟甚至服务中断的情况。

幸运的是,DeepSeek 作为一款开源模型,为用户提供了本地部署的解决方案。通过将 DeepSeek 部署到本地终端,用户不仅可以摆脱网络依赖,还能随时随地享受流畅的 AI 体验。本地部署后,DeepSeek 无需联网即可直接运行,彻底解决了在线服务的延迟和宕机问题。而且安全更适合一些工作人员。这次搬主题分享一下DeepSeek本地搭建部署详细图文教程给大家。

DeepSeek GitHub:GitHub – deepseek-ai/DeepSeek-V3

ollama 和 vLLM 区别:[[Ollama与vLLM部署对比:哪个更合适?]]

一、为什么要在本地部署DeepSeek?

- 稳定高效:无需担心网络波动或服务器压力,本地部署确保模型始终高效运行。

- 隐私安全:数据完全存储在本地,避免敏感信息外泄,保障用户隐私。

- 灵活便捷:支持离线使用,随时随地调用模型,满足多样化需求。

- 开源自由:DeepSeek 的开源特性让用户可以根据需求自定义优化,打造专属 AI 工具。

相信大家在使用 DeepSeek 时都会遇到这样的问题:

这是由于 DeepSeek 大火之后访问量比较大,再加上漂亮国大规模、持续的恶意攻击,导致 DeepSeek 的服务器很不稳定。所以,这个此时在本地部署一个 DeepSeek 大模型就非常有必要了。

再者说,有些数据比较敏感,咱也不想随便传到网上去,毕竟安全第一嘛。这时候,本地大模型的优势就凸显出来了。它就在你自己的电脑上运行,完全不用

本地大模型的优缺点分析说完部署,我们来分析一下本地大模型的优缺点,好让大家心里有个数。

(一)优点

- 隐私性高:数据都在本地,不用担心泄露问题,对于一些敏感数据处理来说,这是最大的优势。

-

稳定性强:不受网络影响,只要电脑不坏,模型就能稳定运行,不用担心中途卡顿或者断线。

-

可定制性强:可以根据自己的需求进行调整和优化,想让它做什么功能就做什么功能,灵活性很高。

(二)缺点

-

硬件要求高:大模型对电脑的性能要求不低,如果电脑配置不够,可能会运行很卡,甚至跑不起来。

-

部署复杂:对于小白来说,一开始可能会觉得有点复杂,需要安装各种东西,还得配置参数,不过只要按照教程来,其实也没那么难。

-

维护成本高:如果模型出了问题,可能需要自己去排查和解决,不像在线工具,有问题直接找客服就行。

二、模型选择

DeepSeek R1:推理模型,版本1.5b、7b到671b共七个。

DeepSeek Coder:代码模型,版本1.3b、6.7b、33b。

DeepSeek V2.5、DeepSeek V3:通用模型,版本分别有236b、671b。

各模型的版本,参数量越大,模型功能也越强大,但也需要更多的计算资源。

(一)依据硬件精准选型

打开Ollama官网DeepSeek模型库网址:https://ollama.com/search?q=DeepSeek,你会看到丰富多样的 DeepSeek-R1 模型版本,如 1.5B、7B、32B 等。根据自身电脑硬件配置来选择合适的模型版本至关重要。

以下是本地部署 DeepSeek 系列模型(1.5B、7B、8B、14B、32B)在 Windows、****macOS****、Linux 三个平台的最低和推荐硬件配置指南。配置需求主要基于模型的显存(GPU)、内存(

(二)通用配置原则

- 模型显存占用(估算):

- 每 1B 参数约需 1.5-2GB 显存(FP16 精度)或 0.75-1GB 显存(INT8/4-bit 量化)。

- 例如:32B 模型在 FP16 下需约 48-64GB 显存,量化后可能降至 24-32GB。

- 内存需求:至少为模型大小的 2 倍(用于加载和计算缓冲)。

- 存储:建议 NVMe SSD,模型文件大小从 1.5B(约 3GB)到 32B(约 64GB)不等。

DeepSeek-R1各版本硬件要求和使用说明:

- 1.5b 大小的模型通常至少需要 8GB RAM,针对边缘设备上的快速推理进行优化的轻量级版本。

-

7b 大小的模型通常至少需要 16GB RAM,适用于通用推理任务的平衡模型。

-

8b 大小的模型通常至少需要 32GB RAM,有更高的准确性和更好的上下文理解。

-

14b 大小的模型通常至少需要 64GB RAM,推理和解决问题的能力得到提高。

-

32b 大小的模型通常至少需要 128GB RAM,更强的逻辑分析和更精细的逐步输出。

-

70b 大小的模型通常需要至少 256GB RAM,适用于高级人工智能驱动应用程序的高端版本。

-

671b 大小的模型通常需要至少 512GB RAM ,专家混合 (MoE) 模型,每个令牌激活 370 亿个参数,以实现最先进的推理性能。

(三)分平台配置建议

以下按模型规模和平台分类,提供 最低配置 和 推荐配置。

1. 1.5B 模型

| 平台 | 最低配置 | 推荐配置 |

|---|---|---|

| Windows | – CPU: Intel i5 / Ryzen 5 | – CPU: Intel i7 / Ryzen 7 |

| – RAM: 8GB | – RAM: 16GB | |

| – GPU: NVIDIA GTX 1650 (4GB) | – GPU: RTX 3060 (12GB) | |

| macOS | – M1/M2 芯片(8GB 统一内存) | – M1 Pro/Max 或 M3 芯片(16GB+) |

| Linux | – CPU: 4 核 | – CPU: 8 核 |

| – RAM: 8GB | – RAM: 16GB | |

| – GPU: NVIDIA T4 (16GB) | – GPU: RTX 3090 (24GB) |

2. 7B/8B 模型

| 平台 | 最低配置 | 推荐配置 |

|---|---|---|

| Windows | – CPU: Intel i7 / Ryzen 7 | – CPU: Intel i9 / Ryzen 9 |

| – RAM: 16GB | – RAM: 32GB | |

| – GPU: RTX 3060 (12GB) | – GPU: RTX 4090 (24GB) | |

| macOS | – M2 Pro/Max(32GB 统一内存) | – M3 Max(64GB+ 统一内存) |

| Linux | – CPU: 8 核 | – CPU: 12 核 |

| – RAM: 32GB | – RAM: 64GB | |

| – GPU: RTX 3090 (24GB) | – 多卡(如 2x RTX 4090) |

3. 14B 模型

| 平台 | 最低配置 | 推荐配置 |

|---|---|---|

| Windows | – GPU: RTX 3090 (24GB) | – GPU: RTX 4090 + 量化优化 |

| – RAM: 32GB | – RAM: 64GB | |

| macOS | – M3 Max(64GB+ 统一内存) | – 仅限量化版本,性能受限 |

| Linux | – GPU: 2x RTX 3090(通过 NVLink) | – 多卡(如 2x RTX 4090 48GB) |

| – RAM: 64GB | – RAM: 128GB |

4. 32B 模型

| 平台 | 最低配置 | 推荐配置 |

|---|---|---|

| Windows | & |

– 需企业级 GPU(如 RTX 6000 Ada) |

| macOS | – 无法本地部署(硬件限制) | – 云 API 调用 |

| Linux | – GPU: 4x RTX 4090(48GB 显存) | – 专业卡(如 NVIDIA A100 80GB) |

| – RAM: 128GB | – RAM: 256GB + PCIe 4.0 SSD |

(四)平台差异说明

- Windows:

- 依赖 CUDA 和 NVIDIA 驱动,推荐使用 RTX 30/40 系列。

- 大模型(14B+)需借助量化或模型分片技术。

- macOS:

- 仅限 Apple Silicon 芯片(M1/M2/M3),依赖 Metal 加速。

- 模型规模超过 14B 时性能显著下降,建议量化或云端部署。

- Linux:

- 支持多 GPU 扩展和高效资源管理(如 NVIDIA Docker)。

- 适合部署大型模型(14B+),需专业级硬件。

[!warning] 注意事项

– 量化优化:使用 4-bit/8-bit 量化可大幅降低显存需求(如bitsandbytes[6])。

– 框架支持:优先选择优化好的库(如 vLLM、DeepSpeed、HuggingFace)。

– 散热:长时间推理需确保散热(建议风冷/水冷)。

建议根据实际需求选择硬件,并优先在 Linux 环境下部署大模型。

[!tip] 在电脑硬件配置能够支持在本地正常运行 DeepSeek 的情况下,建议优先选择更大的版本进行下载。模型版本越大,DeepSeek越智能,用户体验也会越好。**

三、模型下载

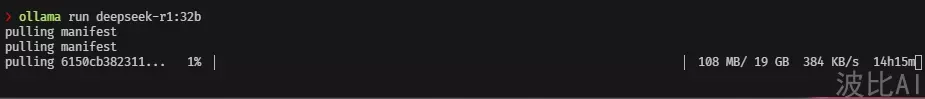

确定适合自己电脑配置的模型版本后,就可以开始下载和运行模型了。打开终端或 CMD 命令窗口,输入对应的运行指令:

DeepSeek R1 推理模型

DeepSeek-R1-Distill-Qwen-1.5b:`ollama run deepseek-r1:1.5b`

DeepSeek-R1-Distill-Qwen-7b:`ollama run deepseek-r1:7b`

DeepSeek-R1-Distill-lalama-8b:`ollama run deepseek-r1:8b`

DeepSeek-R1-Distill-Qwen-14b:`ollama run deepseek-r1:14b`

DeepSeek-R1-Distill-Qwen-32b:`ollama run deepseek-r1:32b`

DeepSeek-R1-Distill-lalama-70b:`ollama run deepseek-r1:70b`

**DeepSeek Coder 代码模型:**

1.3 billion parameter model:`ollama run deepseek-coder`

6.7 billion parameter model:`ollama run deepseek-coder:6.7b`

33 billion parameter model:`ollama run deepseek-coder:33b`

**DeepSeek V2.5 通用模型:**已升级到下面的V3,建议直接部署V3。

**DeepSeek V3 通用模型:**

DeepSeek-V3-671b:`ollama run deepseek-v3`

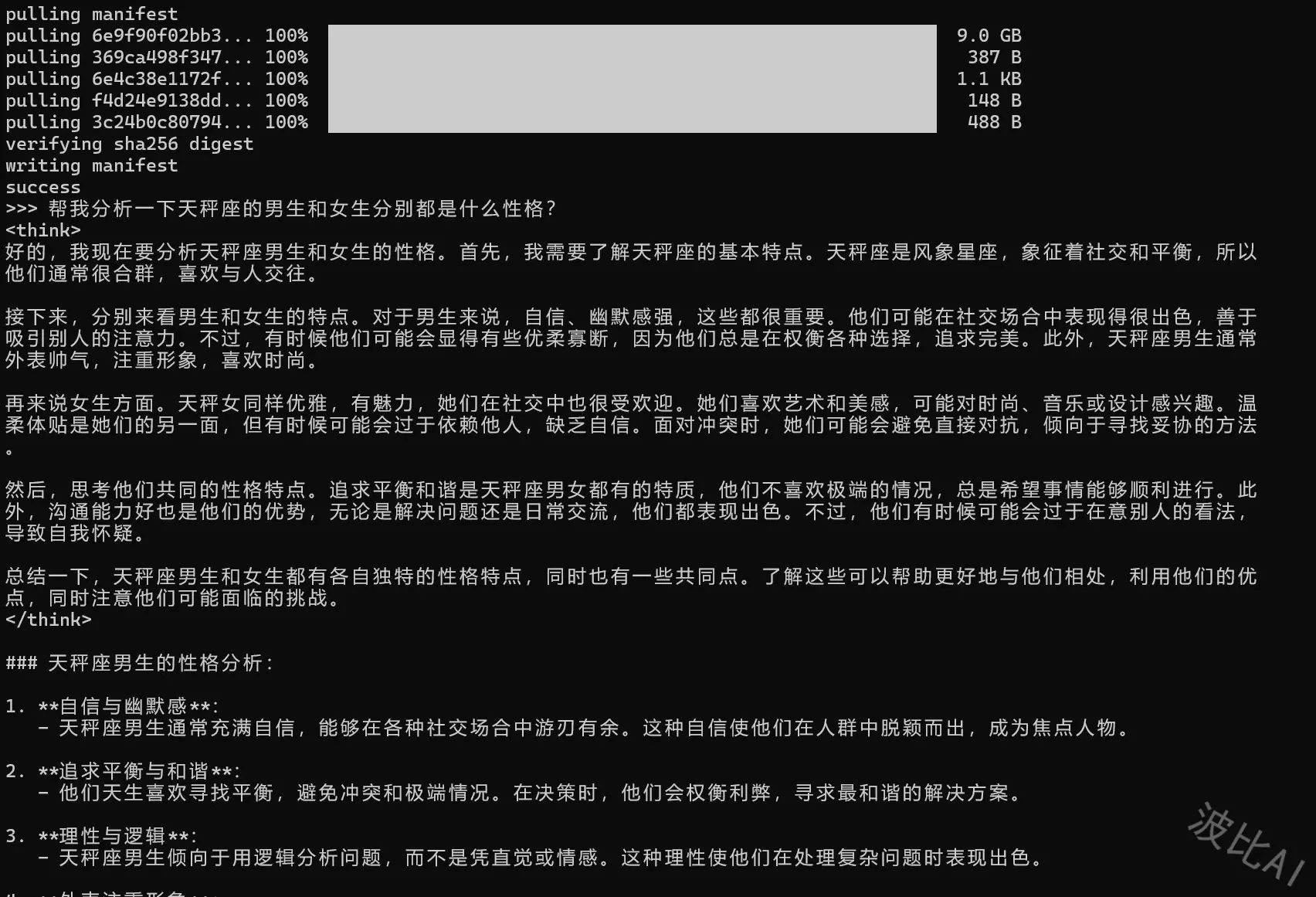

很快,下载完毕会自动加载,完成后,看到>>> Send a message...,意思是启动成功,可以发送消息了:

测试一下是否可以正常与DeepSeek对话:

总结

参考

- [ 1 ]

- [ 2 ]

- [ 3 ]

- [ 4 ]

必须 注册 为本站用户, 登录 后才可以发表评论!