经过 SDXL0.9 和 SDXL Beta 的迭代,终于 SDXL1.0 正式版发布了!

之前使用 AIGC 生成图片,一般都是生成 512512 的图,然后再进行放大,以达到高清出图的要求。但是这里有个问题是底模其实都是海量的 512512 图片训练出来的,所以出图效果上经常不如人意,在细节上会差一些。这次 SDXL1.0 直接使用 1024*1024 的海量图片训练底模,而且分为了文生图用的 base 模型和图生图进行优化和放大的 refiner 模型,从而在开源免费的文生图软件上实现了不输于 Midjourney 的出图效果。

1 – SDXL1.0 简介

1.1 – SDXL 和 SD1.5 模型有什么差别

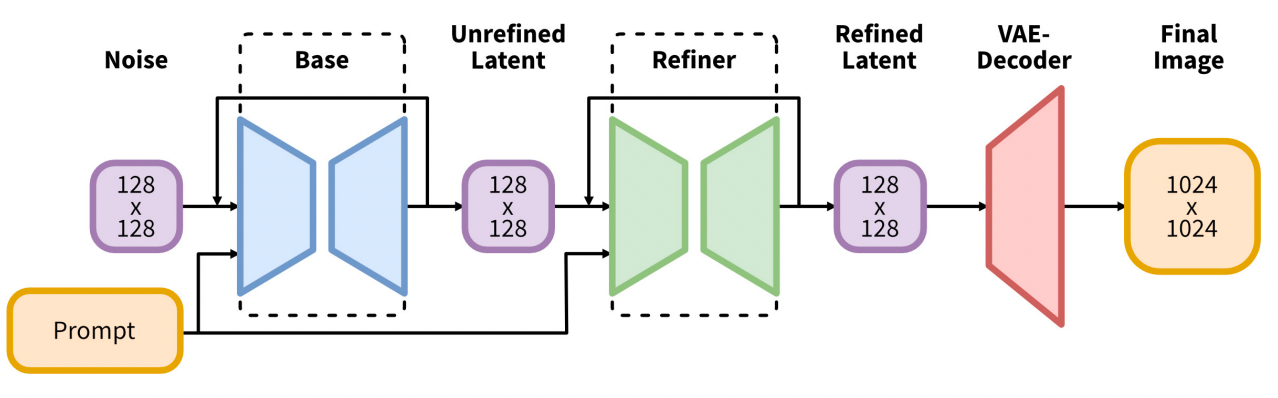

SDXL 与原来的 SD1.5 模型除了大小不同外,最大区别是 SDXL 由 base 基础模型和 refiner 优化模型两组模型构成。您需要先运行基础模型,然后再运行细化模型。基础模型设置全局组成,而细化模型则添加更细节的细节。您也可以选择仅运行基础模型。

语言模型(理解您 Prompt 提示的模块)是最大的 OpenClip 模型(ViT-G/14)和 OpenAI

扩散模型中最重要的部分 U-Net 现在大了 3 倍。加上更大的语言模型,SDXL 模型可以生成与提示紧密匹配的高质量图像。

因为底模是 10241024 训练的,比原来的 512512 大了 4 倍,所以底模 base 基础模型大小也达到接近 7GB,refiner 也是差不多 7GB,对硬件(GPU 显存)的要求更高了!如果只有 8G 以下的显存,建议还是别碰 SDXL 了。

1.2 – 图片的真实感更强

因为对提示词的语义理解更准确,加上底模的分辨率更高,所以对光线、画质、镜头、角度、焦点等等的渲染更到位,以下是我使用提示直接基于 XL base 模型产生的图片。

| photo of young Chinese woman, highlight hair, sitting outside resta |

如果基于这个图再进行图生图,并使用 refiner 模型,那么可以得到更好的效果。

⚠️upload failed, check dev console

1.3 – 对文字的渲染更可靠

之前在 SD1.5 时,是无法在提示词中提升图片中有哪些文字的,现在在 SDXL 中,可以比较好的实现对英文单词的渲染,不过有时候也要看运气,经常也会渲染的有些瑕疵,不过瑕不掩瑜,聊胜于无,总是一个不小的进步。这是提示词:

A fast food restaurant on the moon with name "Devin Burger" |

|---|

这是文生图的一个图片:

另外在二次元、场景渲染上 SDXL 都有不俗的表现,这里就不一一举例了,大家赶紧去体验一下吧!

下面我们就来看看怎么在 Linux 服务器上安装和使用 SDXL1.0 吧。

2 – 安装 SDXL

2.1 – 环境配置

使用与 [[AIGC 实战(环境篇) – 安装部署 Stable Diffusion WebUI]] 一致的环境

2.2 – SDXL1.0 大模型与 vae 下载

当前我们并没有下载

https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0/resolve/main/sd_xl_base_1.0.safetensors

https://huggingface.co/stabilityai/stable-diffusion-xl-refiner-1.0/resolve/main/sd_xl_refiner_1.0.safetensors

这两个文件是底模,大约 7 个 G 每个文件,下载到 GPU 服务器后,需要放到 stable-diffusion-webui/models/Stable-diffusion 文件夹中。另外还有一个 VAE 文件,是可选的,下载地址:

https://huggingface.co/stabilityai/sdxl-vae/resolve/main/sdxl_vae.safetensors

下载后放到 stable-diffusion-webui/models/VAE 文件夹中。

然后我们来 SD WebUI,刷新底模列表,即可看到 XL 的 base 和 refiner 模型。

至于 VAE,默认是不显示在 UI 中的,可以在设置的用户界面选项中添加。接下来就可以在 SD WebUI 中享受 SDXL 带来的新体验吧!

3 – 总结

1.之前在 SDXL1.0 发布之前,需要给 sd-webui 安装 Demo 扩展才能使用 SDXL,现在不需要了,所以如果之前已经安装了 Demo 扩展的可以删除掉了。

2.直接出尺寸在 1024 或者之上的图,不要出 512*512 的图。

3.之前下载的 Lora 和底模、Embedding 等都不能在 SDXL1.0 上使用,所以需要重新从 C 站下载专门的 SDXL 版。很多 Lora 都没有出 XL 版 Lora,所以大家还是等等生态丰富了再作为生产工具吧。

4.Lora 训练工具也更新了,有对应的 SDXL 版本分支,所以要搞 Lora 训练的同学,记得切换训练工具的版本,重新训练属于自己的 XL Lora。

参考:

Stable Diffusion XL1.0正式发布了,赶紧来尝鲜吧

同系列

[[AIGC 实战(环境篇) – 安装部署 SDXL]]

[[AIGC 实战(环境篇) – 安装部署 Ollama]]

[[AIGC 实战(环境篇) – 安装部署 ComfyUI]]

[[AIGC 实战(环境篇) – 安装部署 SDXL1.0]]

[[AIGC 实战(环境篇) – Anaconda 使用教程]]

[[AIGC 实战(环境篇)—— Debian安装Chattts]]

[[AIGC 实战(环境篇) – 安装部署模型训练工具 Kohya_ss]]

[[AIGC 实战(环境篇) – EXSI 8.0 安装 Debian12]]

[[AIGC 实战(环境篇)—— 安装部署 MoneyPrinterPlus]]

[[AIGC 实战(环境篇) – Python、Anaconda、PyTorch安装]]

[[AIGC 实战(环境篇) – 安装部署 Stable Diffusion WebUI]]

[[AIGC 实战(环境篇) – EXSI 8.0 Debian安装RTX3060显卡驱动]]

[[AIGC 实战(环境篇) – 安装部署 Tabby —— AI 自动补全工具 的私有化部署]]

[[AIGC 实战(环境篇) – 部署SadTalker并添加到Stable Diffusion]]

必须 注册 为本站用户, 登录 后才可以发表评论!