一、Midjourney&Stable Diffusion特征差异

整体来说MJ适合需要快速产出、风格多变的商业环境和个人创作,SD适合对图像细节有高要求的艺术创作和技术开发,者的对照表如下表:

| 特性 | Midjourney(MJ) | Stable Diffusion(SD) |

|---|---|---|

| 收费方式 | 收费,提供不同级别的订阅套餐 | 完全开源且免费 |

| 设备要求 | 无具体硬件要求,使用云计算,任何设备均可访问 | 对电脑性能有较高要求,尤其是显卡 |

| 安装部署 | 无需安装,基于网页或APP,通过Discord使用 | 需要手动安装,使用门槛较高 |

| 易用性 | 界面友好,操作简单,新手友好 | 界面和操作相对复杂,适合有一定技术背景的用户 |

| 风格多样性 | 风格多样,能轻松驾驭各种画风 | 风格略显单一,但在技术细节控制上表现出色 |

| 出图效率 | 高效,尤其在开启turbo模式时,输出速度非常快 | 较慢,受限于用户硬件配置 |

| 创意灵活性 | 强大的创意灵活性,适合快速生成创意图片 | 灵活性较MJ略低,但更适合精细控 |

| 技术支持 | 作为商业产品,提供正规的技术支持和用户服务 | 主要停靠社区支持,官方直播的技术支持较少 |

| 适用场景 | 适合需要快速产出、风格多变的商业环境和个人创作 | 适合对图像细节有高要求的艺术创作和技术开发 |

二、AIGC绘图的短板

给人很直观的感觉就是AIGC不懂设计,也不懂产品,还不好驯服,事实上目前AIGC绘图的商业能力还很有限,并且人机交互的沟通成本并不小(你要通过适当的关键词描述需求),当你不能熟悉关键词的应用以及AIGC绘制的功能操作方式时,开启AIGC绘图工具后就像是刚刚新建画板Photoshop,强大且不知所措,AIGC绘图工具的智能化、工业化、多模态交互、傻瓜式都还面临不少挑战。

| 缺陷 | 缺陷描述 |

|---|---|

| 缺乏工业规范理解 | 不能对商业化的要求与行业规范做出正确的响应,缺乏商业化场景能力 |

| 缺乏信息内容的理解 | 对于文本信息、特定标识、特定术语、地域文化等理解和生成能力欠缺 |

| 绘制精度和逻辑欠缺 | 对于事物的理解能力还不足,浓艳一些事物的局部细节或画面逻辑上出错 |

| 不具备较高可控性 | 无法对于空间、布局、色彩、信息、造型等内容进行精细化的控制生成 |

| 不支持图层或多通道 | 画面没有图层或多通道支持,没办法对图像中对象进行独立调整或切图等 |

| 输入可解释性有限 | 受到关键词控制的形式,复杂场景难以解释到位并生成理想结果 |

| 缺乏共情与创造性 | 还无法像人类一样赋予丰富的情感化理解与创造性去生成画面 |

| 图像互动性欠缺 | 图像中的多个对象或是与背景元素间不能灵活的互动 |

| 模糊的版权所有 | AI绘图是基于现有文明与图像艺术进行训练的,缺乏法律保护并伴有侵权的可能 |

三、为何考虑用SD做设计解题?

我简单概括为三个方面:成本更低、可控性更高、有更多的可能性:

1. 成本更低

成本一直是企业或个人关心的问题,在AIGC绘图生成的过程中充满了太多的不确定性了,市面上大多AIGC绘图工具都是收费或签到制的,在不断抽卡中余额消耗的极快,而开源免费的Stable Diffusion无疑是雪中送碳。

通常设计师的电脑也都不算差劲,尽管现在SD还有一些硬件或系统兼容的问题,但是我认为不久的将来,强大的开源社区会给出更好的方案。

2. 可控性更高

设计师不同于纯粹的艺术家,设计即代表有精细的布局与控制,而图像内容的可控性就在

初阶段的SD给人的印象也还是基于模型画画纸片人,并支持一些涂涂换换的能力,直到相关开源社区出现了更多的模型、Lora以及颠覆性的ControlNet控制网络时,我看到的了SD更高的可控性与可能性,这是AIGC绘图跨入工业化的一大步!

3. 更多的可能性

开源社区的魅力就是为爱发电多,商业化场景的应用模型越来越完善,未来充满了各种可能,你根本不知道何时就会出现一款现象级插件或模型,并且市面上可能会出现更多基于Diffusion二开的商业场景应用,我相信在未来SD步入工业化的脚步会越来越快,设计师应用的场景也会更广阔,即使你现在不使用SD,但依旧值得期待一下!

四、版本演变

1. Latent Diffusion

Stable Diffusion 之前的版本,对应的正是论文的开源版本,位于代码库 High-Resolution Image Synthesis with Latent Diffusion Models 中。

该版本发布于 2022 年 4 月,主要包含三个模型:

文生图模型:基于 LAION-400M 数据集训练,包含 1.45B 参数。

图像修复模型:指定区域进行擦除。

基于 ImageNet 的类别生成模型:在 ImageNet 上训练,指定类别条件生成,获得了 3.6 的 FID 分数。使用了 Classifier Free Guidance 技术。

代码实现参考了 OpenAI 的 Diffusion Models Beat GANs 代码实现。

2. Stable Diffusion V1

Stable Diffusion 的第一个版本,特指文生图扩散模型,位于代码库 GitHub – CompVis/stable-diffusion: A latent text-to-image diffusion model 中。

该版本发布于 2022 年 8 月,该模型包含 2 个子模型:

AutoEncoder 模型:U-Net,8 倍下采样,包含 860M 参数。

Text Encoder 模型:使用 CLIP ViT-L/14 中的 Text encoder。

模型首先在 256×256 的分辨率下训练,然后在 512×512 的分辨率下微调。总共包含 4 个子版本:

sd-v1-1.ckpt:

在 LAION-2B-en 数据集上以 256×256 分辨率训练 237k step。

在 LAION-high-resolution(LAION-5B 中超过 1024×1024 分辨率的 170M 样本)上以 512×512 分辨率继续训练 194k step。

sd-v1-2.ckpt:

复用 sd-v1-1.ckpt,在 LAION-aesthetics v2 5+(LAION-2B-en 中美观度分数大于 5.0 的子集) 上以 512×512 分辨率继续训练 515k step。

sd-v1-3.ckpt:

复用 sd-v1-2.ckpt,在 LAION-aesthetics v2 5+ 上以 512×512 分辨率继续训练 195k step,使用了 Classifier Free Guidance 技术,以 10% 概率删除文本条件。

sd-v1-4.ckpt:

复用 sd-v1-2.ckpt,在 LAION-aesthetics v2 5+ 上以 512×512 分辨率继续训练 225k step,使用了 Classifier Free Guidance 技术,以 10% 概率删除文本条件。

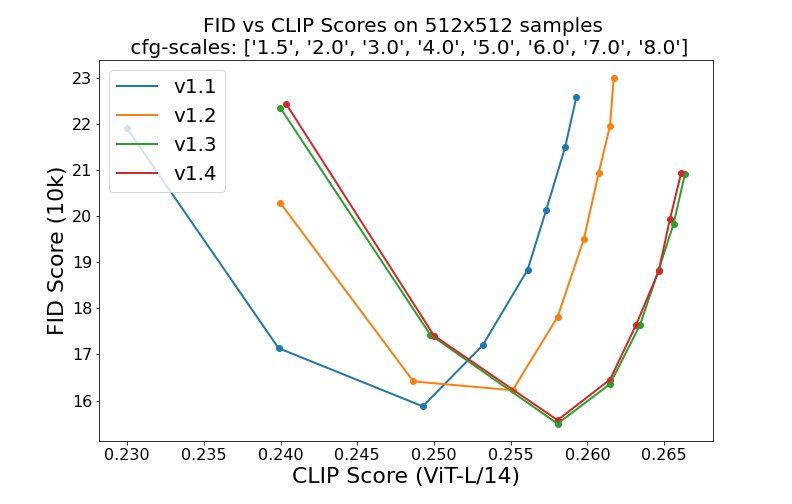

对应的 FID 和 CLIP 分数如下图所示,可见从 v1-1 到 v1-2,再到 v1-3 提升都很明显,v1-3 和 v1-4 差距不大:

3. Stable Diffusion V1.5

Stable Diffusion 的 V1.5 版本,由 runway 发布,位于代码库 GitHub – runwayml/stable-diffusion: Latent Text-to-Image Diffusion 中。

该版本发布于 2022 年 10 月,主要包含两个模型:

sd-v1-5.ckpt:

复用 sd-v1-2.ckpt,在 LAION-aesthetics v2 5+ 上以 512×512 分辨率继续训练 595k step,使用了 Classifier Free Guidance 技术,以 10% 概率删除文本条件。

sd-v1-5-inpainting.ckpt:

复用 sd-v1-5.ckpt,在 LAION-aesthetics v2 5+ 上以 512×512 分辨率以 inpainting 训练了 440k step,使用 Classifier Free Guidance 技术,以 10% 概率删除文本条件。在 U-Net 的输入中额外加了 5 个 channel,4 个用于 masked 的图像,1 个用于 mask 本身。

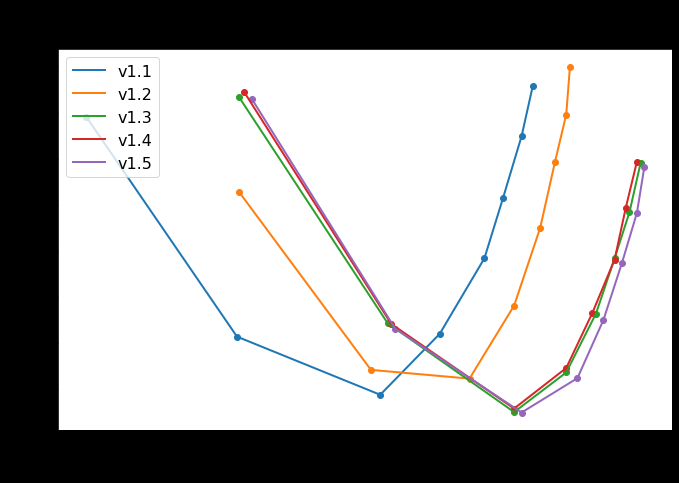

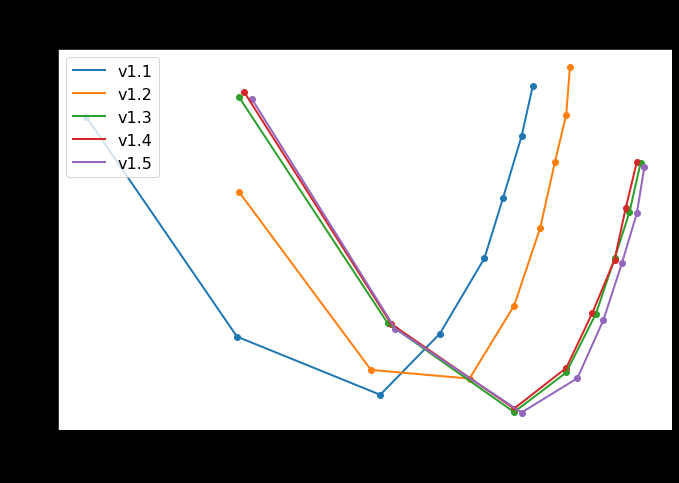

对应的 FID 和 CLIP 分数如下图所示,可以看出,v1.5 相比 v1.4 的提升也不是很明显:

6.3. Stable Diffusion V1.5

Stable Diffusion 的 V1.5 版本,由 runway 发布,位于代码库 GitHub – runwayml/stable-diffusion: Latent Text-to-Image Diffusion 中。

该版本发布于 2022 年 10 月,主要包含两个模型:

sd-v1-5.ckpt:

复用 sd-v1-2.ckpt,在 LAION-aesthetics v2 5+ 上以 512×512 分辨率继续训练 595k step,使用了 Classifier Free Guidance 技术,以 10% 概率删除文本条件。

sd-v1-5-inpainting.ckpt:

复用 sd-v1-5.ckpt,在 LAION-aesthetics v2 5+ 上以 512×512 分辨率以 inpainting 训练了 440k step,使用 Classifier Free Guidance 技术,以 10% 概率删除文本条件。在 U-Net 的输入中额外加了 5 个 channel,4 个用于 masked 的图像,1 个用于 mask 本身。

对应的 FID 和 CLIP 分数如下图所示,可以看出,v1.5 相比 v1.4 的提升也不是很明显:

如下图所示为图像修复的示例:

4. Stable Diffusion V2

Stable Diffusion 的 V2 版本,由 Stability-AI 发布,位于代码库 GitHub – Stability-AI/stablediffusion: High-Resolution Image Synthesis with Latent Diffusion Models 中。

V2 包含三个子版本,分别为 v2.0,v2.1 和 Stable UnCLIP 2.1:

v2.0:

发布于 2022 年 11 月,U-Net 模型和 V1.5 相同,Text encoder 模型换成了 OpenCLIP-ViT/H 中的 text encoder。

SD 2.0-base:分别率为 512×512

SD 2.0-v:基于 2.0-base 微调,分辨率提升到 768×768,同时利用 [2202.00512] Progressive Distillation for Fast Sampling of Diffusion Models 提出的技术大幅降低 Diffusion 的步数。

发布了一个文本引导的 4 倍超分模型。

基于 2.0-base 微调了一个深度信息引导的生成模型。

基于 2.0-base 微调了一个文本信息引导的修复模型。

v2.1:

发布于 2022 年 12 月,模型结构和参数量都和 v2.0 相同。并在 v2.0 的基础上使用 LAION 5B 数据集(较低的 NSFW 过滤约束)微调。同样包含 512×512 分辨率的 v2.1-base 和 768×768 分辨率的 v2.1-v。

Stable UnCLIP 2.1:

发布于 2023 年 3 月,基于 v2.1-v(768×768 分辨率) 微调,参考 OpenAI 的 DALL-E 2(也就是 UnCLIP),可以更好的实现和其他模型的联合,同样提供基于 CLIP ViT-L 的 Stable unCLIP-L 和基于 CLIP ViT-H 的 Stable unCLIP-H。

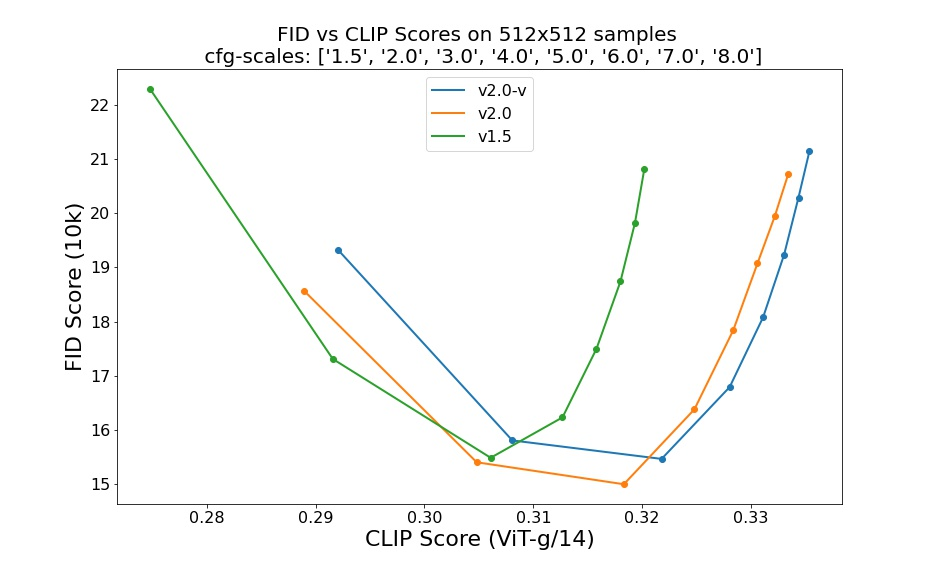

如下图所示为 v2.0 和 v2.0-v 与 v1.5 的对比,可见其都有明显提升:

5. Stable Diffusion XL

Stable Diffusion 的 XL 版本,由 Stability-AI 发布,位于代码库 Generative Models by Stability AI。

该版本发布于 2023 年 06 月,主要包含两个模型:

SDXL-base-0.9:基于多尺度分辨率训练,最大分辨率 1024×1024,包含两个 Text encoder,分别为 OpenCLIP-ViT/G 和 CLIP-ViT/L。

SDXL-refiner-0.9:用来生成更高质量的图像,不应直接使用,此外文本条件只使用 OpenCLIP 中的 Text encoder。

2023 年 07 月发布 1.0 版本,同样对应两个模型:

SDXL-base-1.0:基于 SDXL-base-0.9 改进。

SDXL-refiner-1.0:基于 SDXL-refiner-0.9 改进。

2023 年 11 月发表 SDXL-Trubo 版本,也就是优化加速的版本。

6. Stable Diffusion 1.6

2023 年 11 月发布,只能在 Stability AI Developer Platform 的 v1 API 中使用,是 Stable Diffusion 1.5 的 fine tune 版本。

Stable Diffusion 1.6:据说能生成比 1.5 更好的图片。

7. Stable Diffusion XL Turbo (SDXL Turbo)

2023 年 11 月,Stability AI 推出了高速生成图片的版本,将一般 30~40 步的生成步数,大幅减少到 1~4 步。

SDXL Turbo:从 SDXL 加上 Adversarial Diffusion Distillation (ADD) 技术蒸馏而成,生成图片所需步数减少,但效果略为模糊。

SD Turbo:Stable Diffusion 2.1 的 Turbo 版本。

8. Stable Video Diffusion (SVD)

2023 年 11 月,Stability AI 推出了首个 img2vid 的动画 Model,仅需一张图片即可生成数秒动画。

Stable Video Diffusion:用于生成 14 个影格 576 x 1024 的影片。

Stable Video Diffusion XT:Fine tune 自 Stable Video Diffusion,用于生成 25 个影格 576 x 1024 的影片。

9. Stable Zero 123

2023 年 12 月发布,基于 Zero 123 训练而成,可以生成多方向的图片,即使是背面也可以顺利生成。

Stable Zero 123:效果比 Zero 123 和 Zero 123 XL 更好。

10. Stable Diffusion Cascade

2024 年 2 月,Stability AI 发布了 Stable Diffusio

11. Stable Diffusion XL Lightning (SDXL Lightning)

2024 年 2 月,ByteDance 开发的 SDXL Lightning 发布,不单能在 4~8 步内完成生成,并保持高质量。

12. Stable Diffusion 3

2024 年 2 月,Stability AI 发布了 Stable Diffusion 3,并于 4 月正式公开给公众使用。

Stable Diffusion 3:只有在 Stability AI 提供的 API 中使用,画质和文字识别能力超越以前所有 Model。

Stable Diffusion 3 Turbo:Turbo 版本,生成速度更快。

Stable Diffusion 3 Medium:首个 Open Source 的 Stable Diffusion 3 Model,训练数据量只有 Large 的一半,但理解能力强。

13. Stable Video 3D

2024 年 3 月发布,结合 Stable Video Diffusion 和 Stable Zero 123 的技术,利用单一图片生成一段可以 360 度旋转的动画。

Stable Video 3D:使用一张静态图片生成 21 个影格 576 x 576 的动画。

14. Cos Stable Diffusion XL

2024 年 4 月发布,基于 SDXL 使用 Cosine-Continuous EDM VPred schedule fine tune 而成,可以生成纯黑至纯白的影像。

Cos Stable Diffusion XL 1.0

Cos Stable Diffusion XL 1.0 Edit:特点是可以直接用 prompt 实现 inpaint 效果。

15. Stable Diffusion 3.5

10月22日,Stability AI 发布了其最新的图像生成模型——Stable Diffusion 3.5。作为该系列的新一代产品,Stable Diffusion 3.5 不仅延续了前代模型的强大功能,还在性能、速度和硬件兼容性等方面进行了显著优化。

五、参考

- [ 1 ] Stability AI GitHub

- [ 2 ] stabilityai (Stability AI)

必须 注册 为本站用户, 登录 后才可以发表评论!