在 ControlNet 出现之前,AI 绘画更像开盲盒,在图像生成前,你永远都不知道它会是一张怎样的图。ControlNet 的出现,真正意义上让 AI 绘画上升到生产力级别。简单来说可以用 ControlNet 精准控制 AI 图像的生成效果。

ControlNet 就是在大型扩散生成模型的基础上,再加上一个结构,使得扩散生成模型能够接受一个新的 “图像输入”。并且对模型的输出起到控制作用,使其与输入图像类似。

在实际的 AI 绘图,用户要解决 2 个关键问题:

- 图像的精准控制。例如确定背景、结构等

- 图像的风格控制。例如确定动作、表情等

无论你使用再准确的提示词再好的微调模型也是无法实现的。而通过 ControlNet 的应用模型,可以让这 2 个问题获得解决。所以不仅是常见的人物画像,在建筑、室内、产品图、平面设计、海报等等领域都可以提高生产力甚至做出设计师难以做出的效果。

一、ControlNet(图像精准控制)是什么?

ontrolNet 是一个用于控制 AI 图像生成的插件。它使用了一种称为”Conditional Generative Adversarial Networks̶

看着有点复杂是不是,其实就是解决前文描述的两个问题,也就是:

在 ControlNet 出现之前,我们在生成图片之前,永远的不知道 AI 能给我们生成什么,就像抽卡一样难受。

Con

这下看懂了吗,就很哇塞,大家可能网上看到一些线稿生成的图片,就是用到的这个 ControlNet,Stable Diffusion必装的插件之一。

二、ControlNet 插件安装

ControlNet 在 Stable Diffusion WebUI 中是以插件的形式存在的,大部分 SD WebUI 的整合包或者镜像都已经安装了这个插件,如果你的还没有安装,需要先安装它。已经安装好的跳过这一小节即可。

方法一

打开 Stable Dissusion WebUI 前端页面,进入“扩展插件”-“从网址安装”,在“扩展插件的git仓库网址”中输入:https://github.com/Mikubill/sd-webui-controlnet,然后点击“安装”,待安装完成后重启 SD WebUI。各种 ControlNet 模型和预处理器会在使用时自动下载安装。

方法二

如果访问github不畅,也可以通过别的方式下载插件包和对应的模型,然后自己部署到 stable-diffusion-webui 中。文章最后有我整理的插件包和各种模型的下载地址。

具体部署路径如下:

- ControlNet插件:stable-diffusion-webui/extensions

- ControlNet模型:stable-diffusion-webui/extensions/sd-webui-controlnet/models

- ControlNet预处理器:stable-diffusion-webui/extensions/sd-webui-controlnet/annotator/downloads

注意需替换 stable-diffusion-webui 为你自己的Stable Diffusion WebUI部署路径。

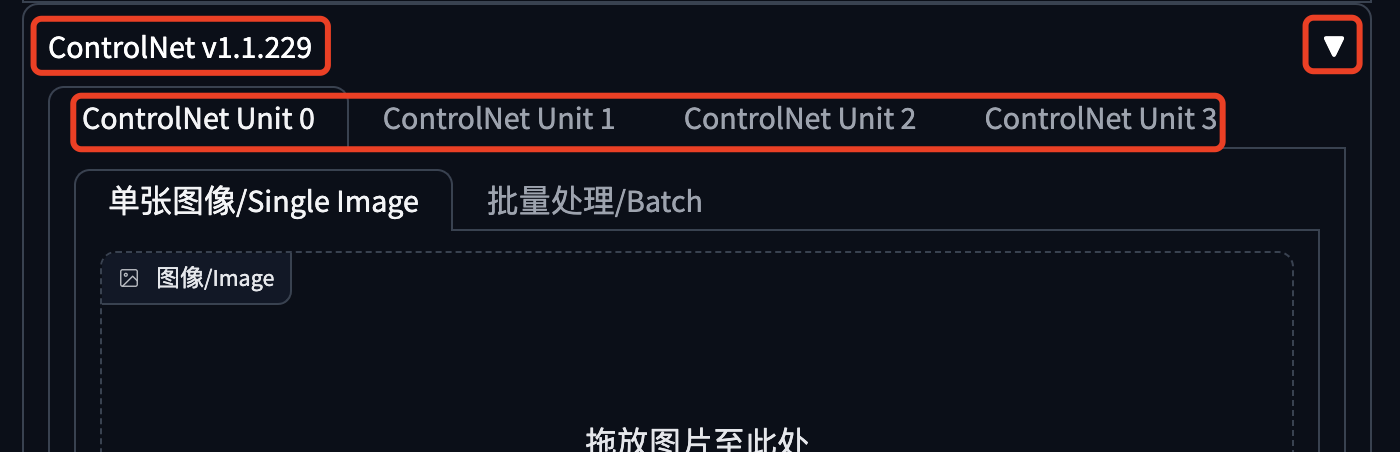

安装成功后,在“文生图”、“图生图”

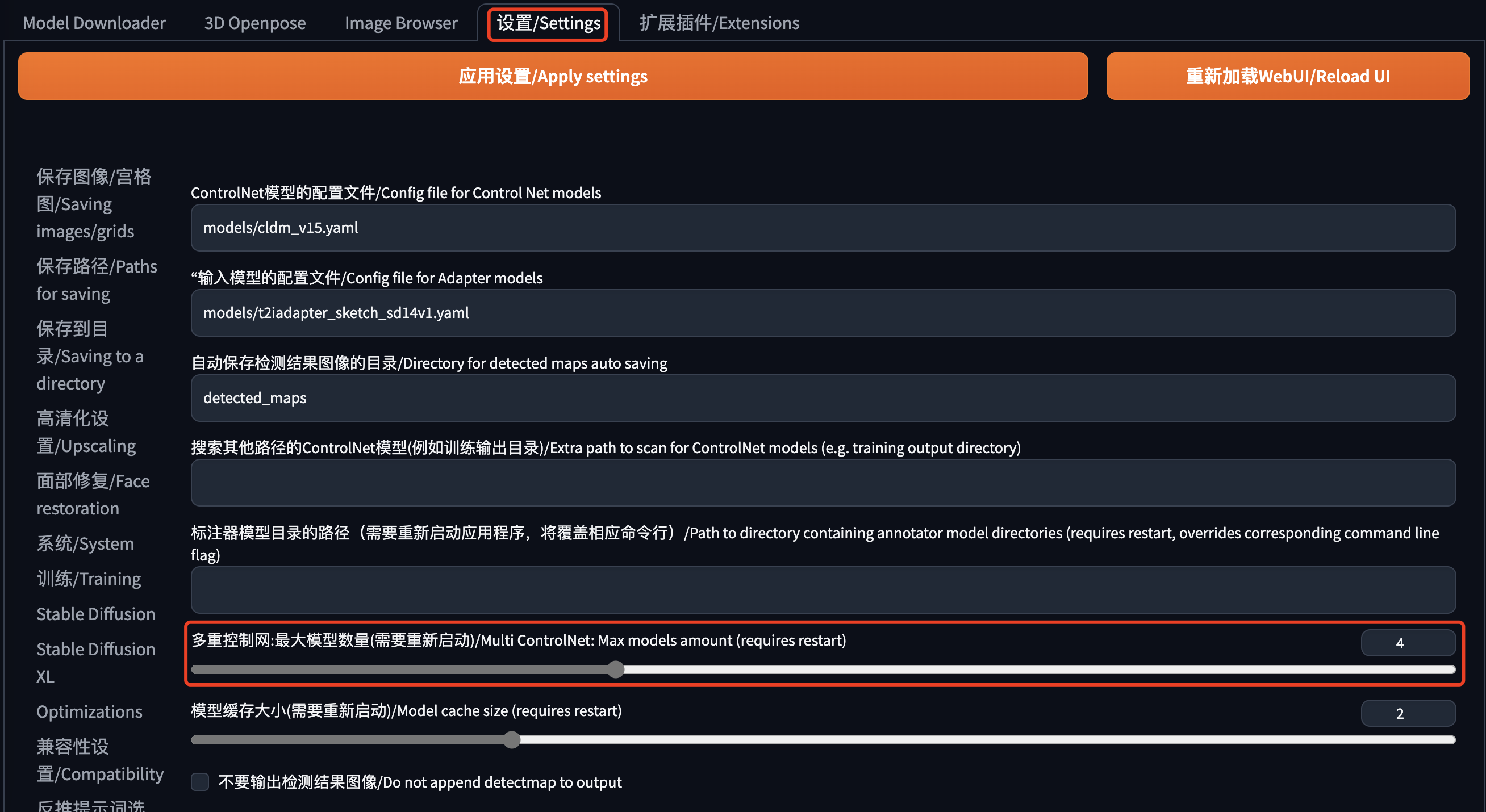

如果你的 ControlNet 只有1个单元,或者你想修改这个单元的数量,可以到“设置”中调整,如下图所示,找到“多重控制网:最大模型数量”,更改之后别忘了重启。

总结

参考

- [ 1 ] Stable Diffusion进阶!姥姥都能看懂的ControlNet超全教程! – 优设网 – 学设计上优设

- [ 2 ]

- [ 3 ]

- [ 4 ]

必须 注册 为本站用户, 登录 后才可以发表评论!