WordPress 建站系列教程 —— Robot.txt 优化

- 独立站

- 2024-04-16

- 50热度

- 0评论

目录

每当我们谈论 Wp 博客的 SEO 时,WordPress robots.txt文件在搜索引擎排名中起着重要作用。它会阻止搜索引擎机器人并帮助索引和抓取我们博客的重要部分。虽然有时,错误配置的 Robots.txt 文件可以让您的存在完全远离搜索引擎。因此,重要的是当您对 robots.txt 文件进行更改时,它应该得到很好的优化,并且不应阻止访问您博客的重要部分。

搜索引擎优化由数百个元素组成,搜索引擎优化的重要部分之一是 Robots.txt。这个位于您网站根部的小文本文件可以帮助您认真优化您的网站。大多数网站管理员倾向于避免编辑 Robots.txt 文件,但这并不像杀死一条蛇那么难。任何有基础知识的人都可以创建和编辑机器人文件,如果您不熟悉这个,这篇文章非常适合您的需要。如果您的网站没 Robots.txt 文件,您可以在此处了解如何操作。如果您的博客/网站有 Robots.txt 文件但没有优化,您可以关注这篇文章并优化您的 Robots.txt 文件。

什么是 WordPress Robots.txt 以及我们为什么要使用它

让我从基础开始。所有搜索引擎都有机器人来抓取网站。爬网和索引是两个不同的术语,如果您想深入了解,可以阅读:Google 爬网和索引。

当搜索引擎机器人(Google 机器人、Bing 机器人、第 3 方搜索引擎抓取工具)通过链接或网站管理员仪表板中提交的站点地图链接访问您的网站时,它们会按照您博客上的所有链接来抓取您的网站并将其编入索引。

现在,这两个文件–Sitemap.xml 和 Robots.txt–驻留在您的域的根目录中。正如我提到的,机器人遵循 Robots.txt 规则来确定对您网站的抓取。以下是 robots.txt 文件的用法:

当搜索引擎机器人出现在您的博客上时,它们用于抓取您网站的资源有限。如果他们无法使用分配的资源抓取您网站上的所有页面,他们将停止抓取,这将妨碍您的索引编制。

现在,与此同时,您网站的许多部分是您不希望搜索引擎机器人抓取的。例如,您的 WP-admin 文件夹、您的管理仪表板或其他对搜索引擎无用的页面。使用 Robots.txt,您可以指示搜索引擎爬虫(机器人)不要爬到您网站的此类区域。这不仅会加快您博客的抓取速度,还有助于深入抓取您的内页。

关于 Robots.txt 文件的最大误解是人们将其用于 Noindexing。

请记住,Robots.txt 文件不适用于 Do Index 或 Noindex。它是指示搜索引擎机器人停止抓取您博客的某些部分。例如,如果您查看 ShoutMeLoud Robots.txt 文件(WordPress 平台),您就会清楚地了解我不希望搜索引擎机器人抓取我博客的哪一部分。

Robots.txt 文件帮助搜索引擎机器人并指示要爬取的部分和避免的部分。当搜索引擎的搜索机器人或蜘蛛来到您的网站并希望为您的网站编制索引时,他们会首先关注 Robots.txt 文件。搜索机器人或蜘蛛遵循文件说明为您网站的页面编制索引或不编制索引。

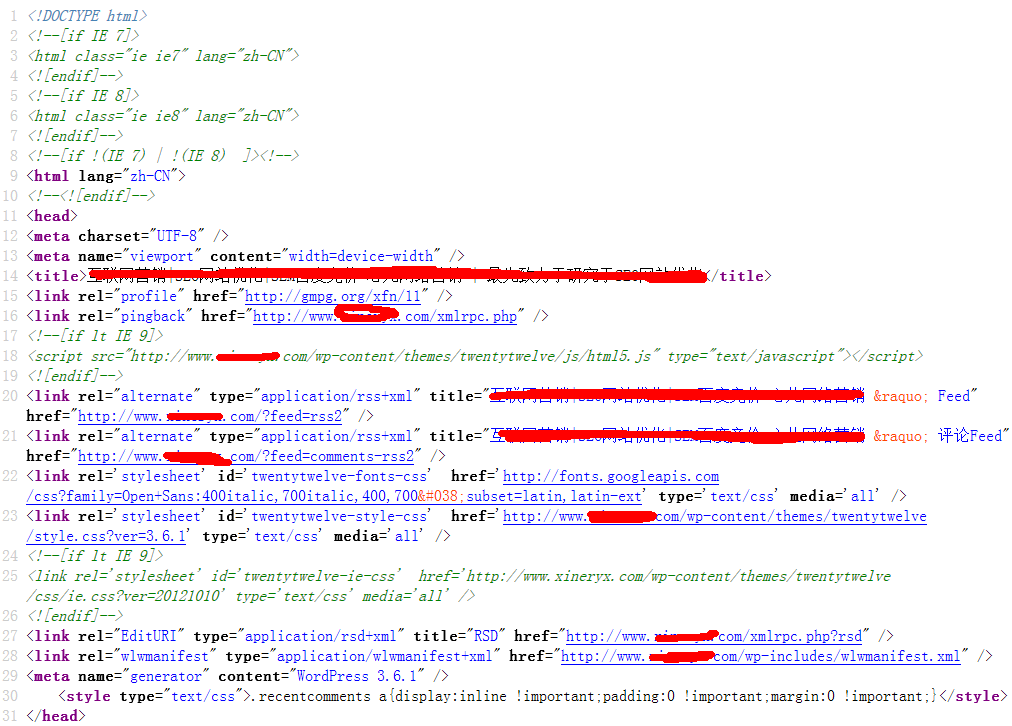

如果您使用 WordPress,您会在 WordPress 安装的根目录中找到 Robots.txt 文件。

对于静态网站,如果您或您的开发人员创建了一个,您将在您的根文件夹中找到它。如果不能,只需创建一个新的记事本文件并将其命名为 Robots.txt,然后使用 FTP 将其上传到域的根目录中。

这是 Robots.txt 文件的示例,您可以看到内容以及它位于域根目录的位置。

https://www.shoutmeloud.com/robots.txt

如何生成 robots.txt 文件?

正如我之前提到的,Robots.txt 是一个通用的文本文件。因此,如果您的网站上没有此文件,请根据需要打开任何文本编辑器(例如记事本)并创建一个包含一条或多条记录的 Robots.txt 文件。每条记录都承载着搜索引擎的重要信息。例子:

User-agent: googlebot

Disallow:/cgi-bin

如果这些行写在 Robots.txt 文件中,则意味着它允许 Google bot 为您网站的每个页面编制索引。但是根目录的 cgi-bin 文件夹 Disallow 索引。这意味着 Google bot 不会索引 cgi-bin 文件夹。

通过使用 Disallow 选项,您可以限制任何搜索机器人或蜘蛛索引页面或文件夹。有许多站点在存档文件夹或页面中不使用索引,以免产生重复的内容。

在哪里可以获得搜索机器人的名称?

您可以在您网站的日志中获取它,但是如果您希望来自搜索引擎的大量访问者,您应该允许每个搜索机器人。这意味着每个搜索机器人都会为您的网站编制索引。您可以编写 User-agent: * 以允许每个搜索机器人。例如:

User-agent: *

Disallow:/cgi-bin

这就是为什么每个搜索机器人都会为您的网站编制索引的原因。

不要在 Robots.txt 文件中使用

- 不要在 Robots.txt 文件中使用注释。

-

不要在任何行的开头保留空格,不要在文件中留普通空格。例子:

\3. 不要改变指挥规则。

不良做法:

Disallow: /support

User-agent:*

良好做法:

User-agent: *

Disallow:/支持

\4. 如果您不想索引多个目录或页面,请不要与这些名称一起写:

不良做法:

User-agent: *

Disallow:/support /cgi-bin /images/

良好做法:

User-agent: *

Disallow:/支持

Disallow:/cgi-bin

Disallow:/图像

\5. 正确使用大小写字母。例如,如果您想索引 " 下载 " 目录,但在 Robots.txt 文件中写入 " 下载 ",则会将其误认为是搜索机器人。

\6. 如果你想索引你网站的所有页面和目录,写:

User-agent: *

Disallow:

\7. 但是如果你不想为你网站的所有页面和目录建立索引,请写:

User-agent: *

Disallow:/

编辑 Robots.txt 文件后,通过任何 FTP 软件将其上传到您站点的根目录或主目录。

WordPress Robots.txt 指南

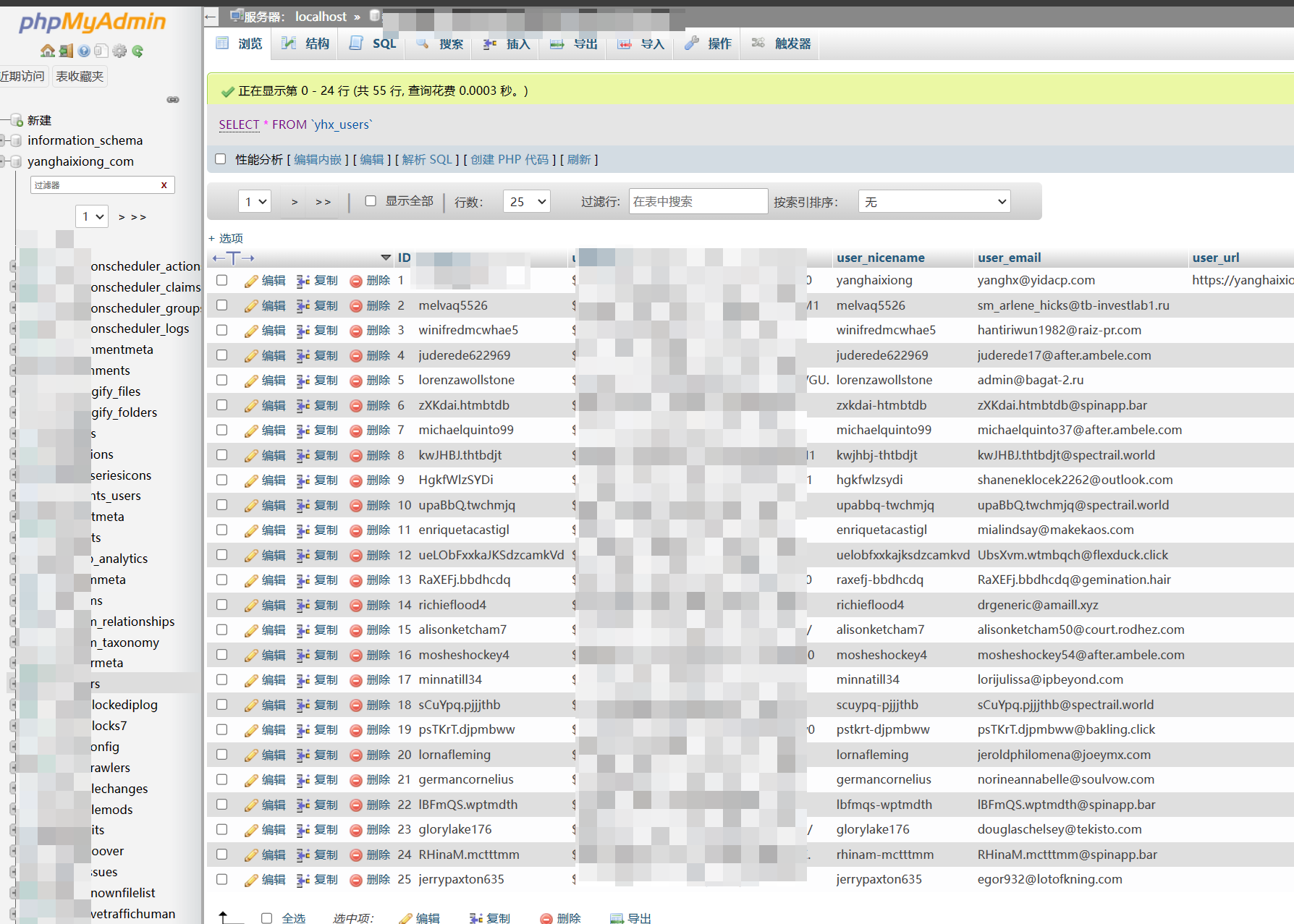

您可以通过登录服务器的 FTP 帐户来编辑 WordPress Robots.txt 文件,也可以使用 Robots meta 等插件从 WordPress 仪表板编辑 Rrobots.txt 文件。您应该将一些内容与站点地图 URL 一起添加到 Robots.txt 文件中。添加站点地图 URL 可帮助搜索引擎机器人找到您的站点地图文件并加快页面索引速度。

以下是适用于任何域的示例 Robots.txt 文件。在站点地图中,将站点地图 URL 替换为您的博客 URL:

站点地图:https://www.shoutmeloud.com/sitemap.xml

User-agent:*

Disallow 这些目录中的所有文件

Disallow:/cgi-bin/

Disallow:/wp-admin/

Disallow:/档案/

Disallow:/*?*

Disallow:*?replytocom

Disallow:/comments/feed/

User-agent:Mediapartners-Google*

允许:/

User-agent:Googlebot-Image

允许:/wp-content/uploads/

User-agent:Adsbot-Google

允许:/

User-agent:Googlebot-Mobile

允许:/

阻止不良 SEO 机器人(完整列表)

有许多 SEO 工具,如 Ahrefs、SEMRush、Majestic 和许多其他工具,它们会不断爬行您的网站以获取 SEO 秘密。您的竞争对手使用这些策略是为了他们的利益,不会为您增加价值。此外,这些 SEO 爬虫还会增加您的服务器的负载并增加您的服务器成本。

除非您不使用这些 SEO 工具之一,否则最好阻止它们抓取您的网站。以下是我在 robots.txt 上使用的内容来阻止一些最流行的 SEO 代理:

User-agent:MJ12bot Disallow:/ User-agent:SemrushBot Disallow:/ User-agent:SemrushBot-SA Disallow:/ User-agent:dotbot Disallow:/ User-agent:AhrefsBot Disallow:/ User-agent:Alexibot Disallow:/ User-agent:SurveyBot Disallow:/ User-agent:Xenu's Disallow:/ User-agent:Xenu 的 Link Sleuth 1.1c Disallow:/ User-agent:rogerbot Disallow:/# 阻止 NextGenSearchBot User-agent:NextGenSearchBot Disallow:/ # 阻止 ia-archiver 爬取站点 User-agent:ia_archiver Disallow:/ # 阻止 archive.org_bot 爬取站点 User-agent:archive.org_bot Disallow:/ # 阻止 Archive.org Bot 爬取站点 User-agent:Archive.org Bot Disallow:/

## 阻止 LinkWalker 从抓取站点 User-agent:LinkWalker Disallow:/

## 阻止 GigaBlast Spider 爬行站点 User-agent:GigaBlast Spider Disallow:/

## 阻止 ia_archiver-web.archive.org_bot 爬取站点 User-agent:ia_archiver-web.archive.org Disallow:/

## 阻止 PicScout Crawler 从抓取站点 User-agent:PicScout Disallow:/

## 阻止 BLEXBot Crawler 爬行站点 User-agent:BLEXBot 爬虫 Disallow:/

## 阻止 TinEye 从爬行站点 User-agent:TinEye Disallow:/

## 阻止 SEOkicks User-agent:SEOkicks-Robot Disallow:/

## 阻止 BlexBot User-agent:BLEXBot Disallow:/

## 阻止 SISTRIX User-agent:SISTRIX 爬虫 Disallow:/

## 阻止正常运行时间机器人 User-agent:UptimeRobot/2.0 Disallow:/

## Block Ezooms 机器人 User-agent:Ezooms 机器人 Disallow:/

## 阻止 netEstate NE Crawler (+[http://www.website-datenbank.de/](http://www.website-datenbank.de/)) User-agent:netEstate NE Crawler (+[http://www.website-datenbank.de/](http://www.website-datenbank.de/)) Disallow:/

## 阻止 WiseGuys 机器人 User-agent:WiseGuys 机器人 Disallow:/

## Block Turnitin 机器人 User-agent:Turnitin Robot Disallow:/

## 阻止 Heritrix User-agent:Heritrix Disallow:/

## 区块价格 pi User-agent:pimonster Disallow:/ User-agent:Pimonster Disallow:/ User-agent:Pi-Monster Disallow:/

## 阻止埃尼罗 User-agent:ECCP/1.0([电子邮件保护])Disallow:/

## 阻止 Psbot User-agent:Psbot Disallow:/

#封锁有道 User-agent:有道机器人 Disallow:/

## BLEXBot User-agent:BLEXBot Disallow:/

## 阻止 NaverBot User-agent:NaverBot User-agent:Yeti Disallow:/

## 阻止 ZBot User-agent:ZBot Disallow:/

## 阻止流浪汉 User-agent:Vagabondo Disallow:/

## 阻止 LinkWalker User-agent:LinkWalker Disallow:/

## 块 SimplePie User-agent:SimplePie Disallow:/

## 阻止 Wget User-agent:Wget Disallow:/

## 阻止 Pixray-Seeker User-agent:Pixray-Seeker Disallow:/

## 阻止 BoardReader User-agent:BoardReader Disallow:/

## 块量化 User-agent:量化 Disallow:/

## 块 Plukkie User-agent:Plukkie Disallow:/

## 块 Cuam User-agent:Cuam Disallow:/

## [https://megaindex.com/crawler](https://megaindex.com/crawler) User-agent:MegaIndex.ru Disallow:/

User-agent:megaindex.com Disallow:/

User-agent:+[http://megaindex.com/crawler](http://megaindex.com/crawler) Disallow:/

User-agent:MegaIndex.ru/2.0 Disallow:/

User-agent:megaIndex.ru Disallow:/

确保没有内容受到新 Robots.txt 文件的影响

所以现在您已经对 Robots.txt 文件进行了一些更改,是时候检查您的任何内容是否因 robots.txt 文件中的更新而受到影响。

您可以使用 Google 搜索控制台的 "Google 抓取工具 " 来查看 Robots.txt 文件是否可以访问您的内容。

这些步骤很简单。

登录到 Google 搜索控制台,选择您的站点,转到诊断和 Google 抓取。

添加您的网站帖子并检查访问您的帖子是否有任何问题。

您还可以在搜索控制台的抓取错误部分下检查由 Robots.txt 文件引起的抓取错误。

在抓取 > 抓取错误下,选择受 Robots.txt 限制,您将看到 Robots.txt 文件拒绝了所有链接。

您可以清楚地看到 Replytocom 链接已被 Robots.txt 拒绝,因此还有其他不应属于 Google 的链接。仅供参考,Robots.txt 文件是 SEO 的基本要素,您可以通过更新 Robots.txt 文件来避免许多帖子重复问题。

您是否使用 WordPress Robots.txt 来优化您的网站?您想为您的 Robots.txt 文件添加更多洞察力吗?使用下面的评论部分让我们知道。不要忘记订阅我们的电子邮件时事通讯,以继续接收更多 SEO 技巧。